L’ÉTÉ DIGITAL – La mixité, une condition indispensable pour une intelligence artificielle non stéréotypée

Data, IoT, conversationnel, cybersécurité, mixité numérique… Découvrez notre sélection des sujets sur “www.digital.sncf.com” et passez un été digital.

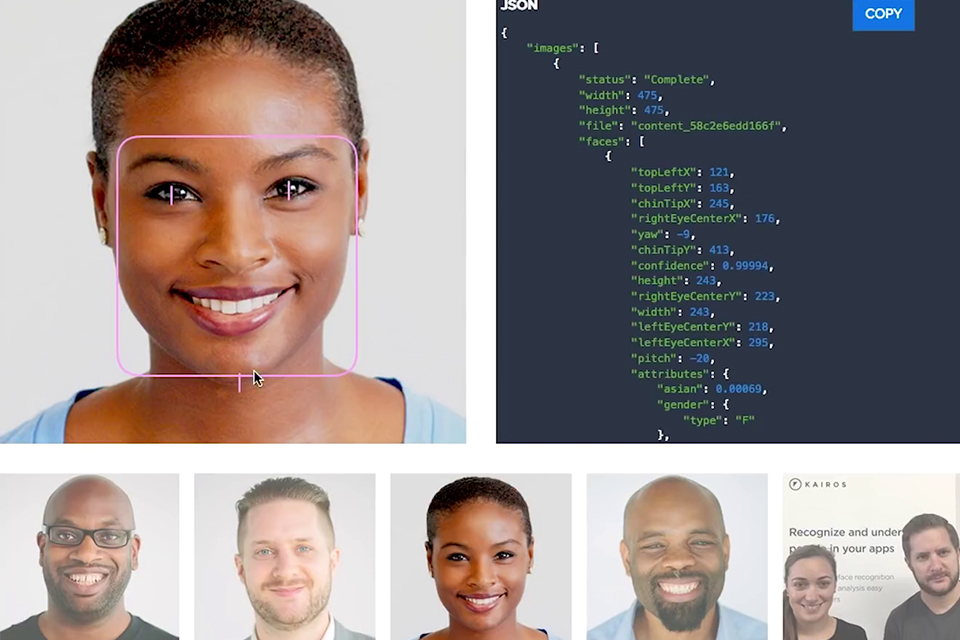

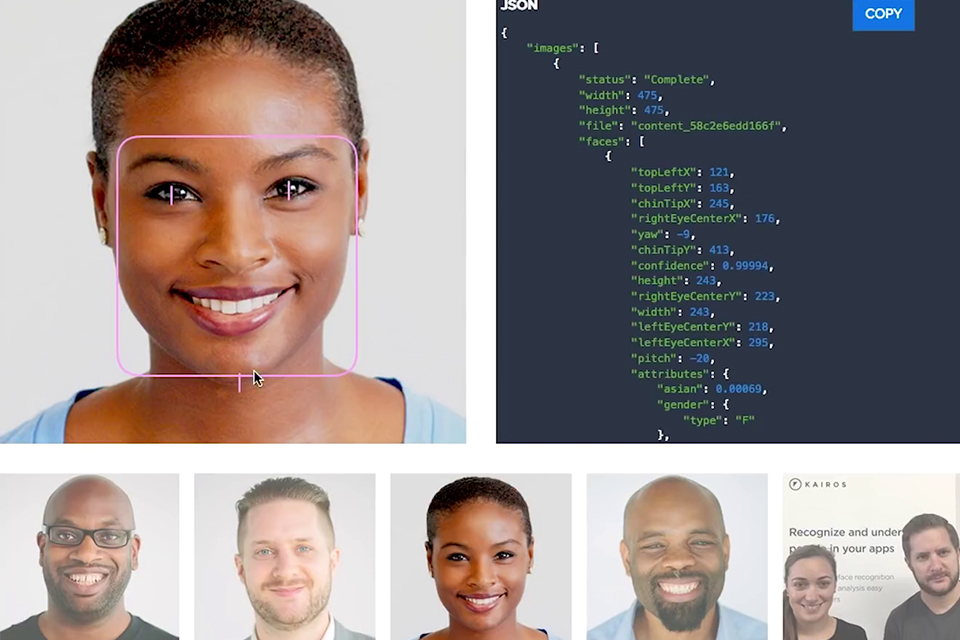

Les algorithmes de reconnaissance faciale n’ont jamais été aussi puissants. D’après le National Institute of Standards and Technology (l’agence du département du Commerce des États-Unis promouvant l’économie de la tech et de l’industrie), entre 2014 et 2018, ils ont augmenté de 20 fois leur capacité à reconnaître un individu à partir d’une base de données photos, avec seulement 0,2% d’échec. En revanche, ils reproduisent exactement les mêmes distorsions déjà existantes dans nos sociétés : leur taux de « faux matchs » arrive à son pic quand il s’agit des images du visage des femmes noires. L’IA est donc sujette d’une réflexion nécessaire autour des biais cognitifs.

Publié le

Par La Redaction

Quels sont les grands défis de la mixité concernant l’IA ?

Aujourd’hui nous avons la preuve par l’exemple des dangers possibles, avec le cas des visages noirs non reconnus, ou celui d’une base de CV RH qui ne sélectionnait pas les CV féminins, car elle avait été élaborée sur des bases de CV masculins. Dans ce cas, on constate une ségrégation de genre, non intentionnelle puisqu’il s’agit d’un robot. Ce dernier apprend via les données fournies, et l’historique étant majoritairement masculin, il sélectionne donc logiquement les CV masculins. C’est le genre de biais que peut induire la programmation. En général, 95% des codeurs sont des hommes blancs, donc ces biais sont intégrés dès le départ.

Quel est le risque des stéréotypes dans l’IA ?

Le risque pour la société concerne d’abord les femmes. Si elles ne prennent pas conscience maintenant de ces stéréotypes, elles risquent d’être exclues du monde numérique en construction, mais aussi des applications et de leur création.

Un monde d’applications qui n’aura pas pris en compte la totalité de la population, or les femmes représentent 50% voire 51% de la population mondiale.

Concrètement, comment lutter contre les biais induits lors de la conception des IA ?

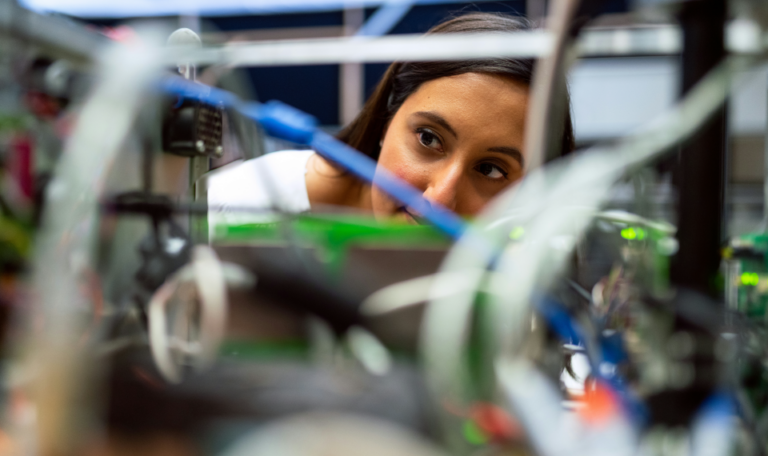

Il y a déjà la base historique soumise à des stéréotypes. Ensuite, si l’IA fait face à des réponses basées sur ces même stéréotypes, elle ne fera que reproduire les biais initiaux. Il faut agir dès la conception, car il est tout à fait possible de faire un code presque “propre”, avec le moins de biais induits possibles ; code qui doit permettre un apprentissage non stéréotypé pour s’approcher au maximum de la diversité représentative de notre société. Avant de lancer une application en production, on fait un échantillonnage. Dans cette phase pilote, il s’agit de faire en sorte que la population utilisatrice soit diversifiée, car cela permettra de déceler les biais induits. Lorsqu’on réalise un prototype et que l’on doit l’industrialiser, il faut prendre en compte l’intégralité des besoins utilisateurs ou clients, et pas uniquement ceux “des hommes blancs”. Les femmes sont aussi clientes et prescriptrices. Il faut donc que les équipes soient mixtes dès le départ, d’où l’importance que les femmes investissent cette sphère professionnelle dès maintenant. C’est d’autant plus primordial que tous les champs de la société sont touchés par la transformation numérique.

Quels sont les leviers pour faire bouger les lignes ?

De nombreuses actions sont menées autour du code, dans les écoles, collèges et lycées pour encourager les jeunes filles et faire tomber les fantasmes : tout le monde peut apprendre à coder. L’Education Nationale va proposer des cours dans ce sens, et le codage sera bientôt au brevet des collèges. Par l’intermédiaire d’associations telles qu’Elles bougent, Cyberelles, Becomtech, il s’agit de déployer pédagogie et explications, pour que les femmes deviennent actrices du monde numérique. J’ai testé l’organisation des coding goûters, pour montrer que les métiers numériques et techniques ne sont pas uniquement dévolus aux hommes, et les petites filles s’y pressent.

Une prise de conscience qui doit toucher les femmes... mais aussi les hommes

Oui, de ce côté-là, on peut parler d’accompagnement au changement, de pédagogie adressée à l’univers masculin. Sensibilisés, les hommes -également empreints de stéréotypes- peuvent alors décrypter leur mode de pensée, prendre conscience des biais et agir. Nous avons, par exemple, des ambassadeurs dans l’ambassade SNCF au Féminin.

On parle souvent de l’importance du “role-model”, pour les jeunes filles notamment. Cela passe aussi par l’impulsion des entreprises comme SNCF ?

Oui, et pour toutes les générations et pas uniquement les jeunes filles qui sont en quête d’orientation, mais aussi pour les femmes en mobilité ou reconversion. Des role-models, des personnes inspirantes qui témoignent et partagent leur vécu dans lesquelles il va être possible de s’identifier, de se projeter, car on ne reproduit que ce que l’on voit.

SNCF propose un programme avec des ateliers pratiques, conférences, débats et tables rondes. Si, en interne, cela est fait pour que les femmes s’y reconnaissent et s’y retrouvent, cela montre l’engagement de SNCF en externe. Nous sommes d’ailleurs membre fondateur de Femmes@numériques, qui agit pour la mixité dans la tech. Il s’agit d’un message fort envoyé aux collaboratrices, à la société civile dans sa globalité, et pour attirer les talents également.

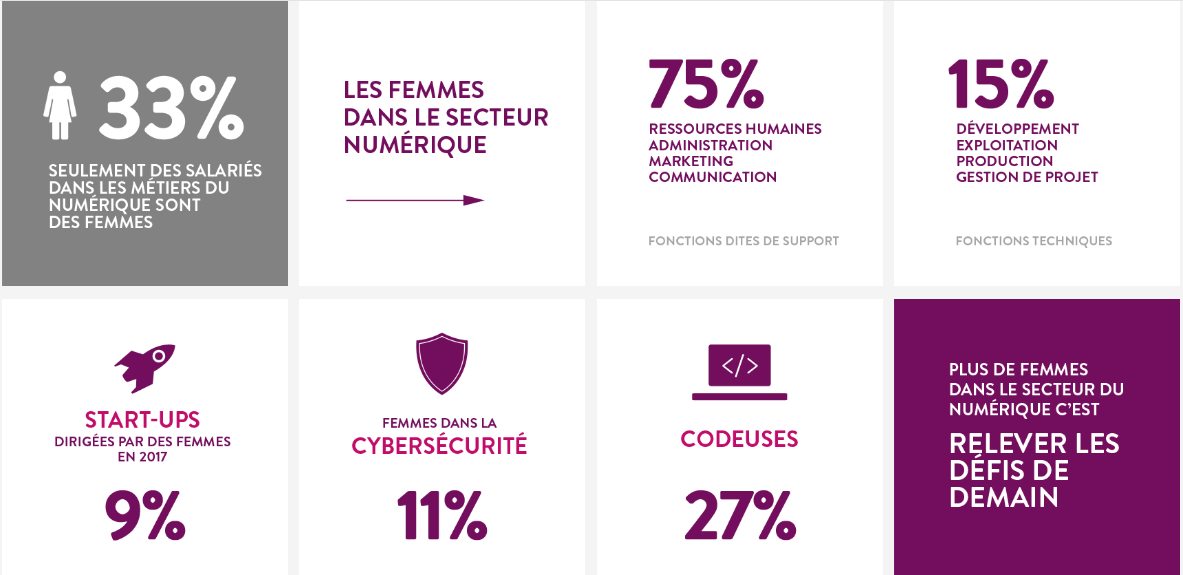

Femmes et Tech en chiffres

Une étude de l’entreprise canadienne Element AI estimait que 12 % des chercheurs en IA dans le monde étaient des femmes (14,8 % en France).